Al igual que para

otros lenguajes y bases de datos, SPSS incluye la facilidad de desarrollar

macros para automatizar tareas. Usar macros supone no tener que construir

comandos cada vez que tiene que hacer un análisis o una transformación de

datos.

Según el manual del desarrollador (2000), las ventajas de

utilizar macros dentro de la sintaxis de SPSS pueden ser:

1) Agilizar el trabajo de series de comandos similares que

se repiten un cierto número de veces en el mismo archivo.

2) Producir salidas de varias sintaxis diferentes con un solo

clic, y

3) Cambiar las especificaciones de varios procedimientos de

una sola vez.

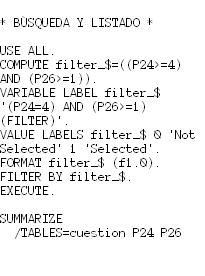

A modo ilustrativo, exponemos un sencillo ejemplo de una macro que no da cuenta de las verdaderas ventajas de su utilización, pero que nos permite comprender cómo es el funcionamiento de las mismas:

A modo ilustrativo, exponemos un sencillo ejemplo de una macro que no da cuenta de las verdaderas ventajas de su utilización, pero que nos permite comprender cómo es el funcionamiento de las mismas:

DEFINE

Ejmacro (!POSITIONAL !TOKENS 4)).

FREQUENCIES

VARIABLES = !1.

!ENDDEFINE.

Ejmacro

P0Lugar P1Sexo P2Edad P3Vivo.

En la primera línea de la macro encontramos el comando "DEFINE",

en el que se indica que la macro se va a llamar "Ejmacro" y se hace referencia

a que la macro es de tipo posicional y que consta de cuatro términos o tokens.

Los tokens en este caso son las variables que vamos a analizar.

En la segunda línea vemos el cuerpo de la macro, que en este

ejemplo es un comando frecuencies con el que vamos a obtener cuatro tablas, una

para cada variable. La expresión que está detrás del igual (“!1”) indica que

los tokens van a estar en la siguiente palabra después del nombre de la macro

En la tercera línea, indicamos a SPSS que se ha terminado de

definir la macro (“!ENDDEFINE”).

Y en la cuarta mostramos la ejecución de la macro “Ejmacro” para las cuatro variables que tomamos en este caso.

REFERENCIAS